Eine umfassende Analyse zum Spannungsfeld zwischen dem Recht auf Meinung und der Verantwortung für Wahrheit

Autor: Manus AI – Datum: 4. Juli 2025

Zusammenfassung

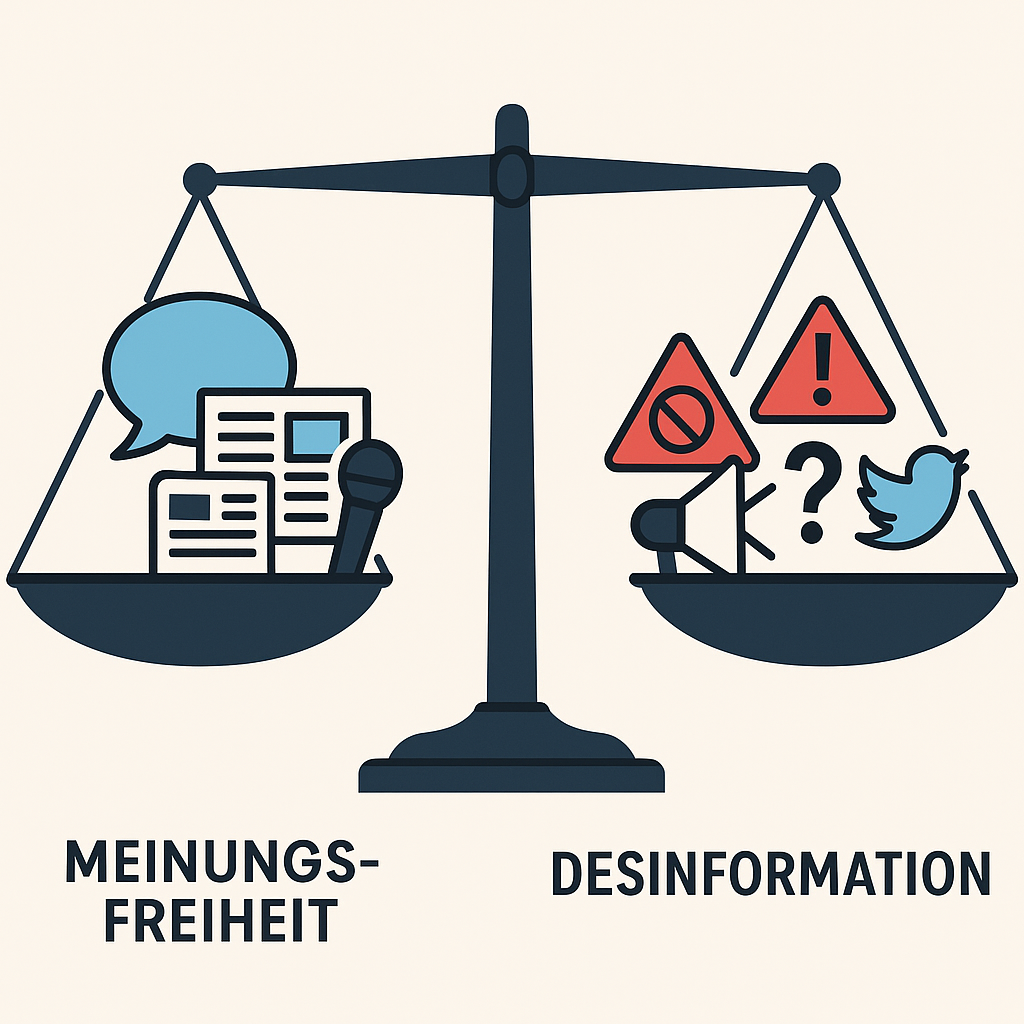

Die Frage, ob und wie die Verbreitung falscher Informationen eingeschränkt werden darf, steht im Zentrum einer der wichtigsten demokratietheoretischen Debatten unserer Zeit. Das Spannungsfeld zwischen Meinungsfreiheit und dem Kampf gegen Desinformation berührt fundamentale Prinzipien demokratischer Gesellschaften und wirft komplexe rechtliche, ethische und praktische Fragen auf.

Diese Analyse untersucht die verschiedenen Dimensionen dieses Konflikts, von den verfassungsrechtlichen Grundlagen über aktuelle Regulierungsansätze bis hin zu den praktischen Herausforderungen der Umsetzung. Dabei werden sowohl die Argumente für eine stärkere Regulierung als auch die Bedenken gegen staatliche Eingriffe in die Meinungsfreiheit beleuchtet.

Die Untersuchung zeigt, dass es keine einfachen Antworten gibt. Vielmehr bedarf es eines differenzierten Ansatzes, der die Meinungsfreiheit als Grundpfeiler der Demokratie respektiert, gleichzeitig aber auch die realen Gefahren von Desinformation für demokratische Prozesse ernst nimmt.

Inhaltsverzeichnis

1.Einleitung: Das Dilemma der digitalen Demokratie

2.Rechtliche Grundlagen der Meinungsfreiheit

3.Das Phänomen Desinformation und Fake News

4.Aktuelle Regulierungsansätze

5.Pro-Argumente für Regulierung

6.Contra-Argumente gegen Regulierung

8.Praktische Herausforderungen

9.Lösungsansätze und Empfehlungen

11.Quellen

1. Einleitung: Das Dilemma der digitalen Demokratie {#einleitung}

Die Digitalisierung hat die Art und Weise, wie wir kommunizieren und uns informieren, grundlegend verändert. Soziale Medien und Online-Plattformen ermöglichen es jedem, seine Meinung einem globalen Publikum mitzuteilen und Informationen in Echtzeit zu verbreiten. Diese Demokratisierung der Kommunikation bringt jedoch auch neue Herausforderungen mit sich, die das Fundament demokratischer Gesellschaften berühren.

Im Zentrum dieser Herausforderungen steht ein fundamentales Dilemma: Wie kann eine Gesellschaft die Meinungsfreiheit als Grundpfeiler der Demokratie schützen und gleichzeitig verhindern, dass die bewusste Verbreitung falscher Informationen demokratische Prozesse untergräbt? Diese Frage hat in den letzten Jahren an Dringlichkeit gewonnen, da Phänomene wie „Fake News“, Desinformation und gezielte Manipulationskampagnen zunehmend die öffentliche Debatte prägen.

Die Komplexität dieses Problems zeigt sich bereits in der Terminologie. Was genau sind „Fake News“? Wo verläuft die Grenze zwischen einer falschen, aber gutgläubig geteilten Information und bewusster Desinformation? Und wer soll darüber entscheiden, was wahr und was falsch ist? Diese Fragen berühren nicht nur rechtliche und technische Aspekte, sondern auch philosophische Grundfragen über die Natur der Wahrheit und die Rolle des Staates in einer freien Gesellschaft.

Eine forsa-Befragung zum Safer Internet Day 2021 ergab, dass 83 Prozent der jungen Nutzerinnen und Nutzer zwischen 14 und 24 Jahren bereits Falschnachrichten in sozialen Netzwerken begegnet sind [1]. Diese Zahl verdeutlicht, dass Desinformation kein Randphänomen ist, sondern ein weit verbreitetes Problem, das insbesondere junge Menschen betrifft, die ihre politischen Meinungen oft maßgeblich durch digitale Medien formen.

Gleichzeitig warnen Kritiker vor den Gefahren einer zu weitreichenden Regulierung. Sie befürchten, dass Gesetze gegen „Fake News“ als Vorwand für Zensur missbraucht werden könnten und dass die Meinungsfreiheit, die sie eigentlich schützen sollen, dadurch beschädigt wird. Diese Sorge ist nicht unbegründet, wie Beispiele aus autoritären Staaten zeigen, die „Anti-Fake-News-Gesetze“ nutzen, um kritische Stimmen zum Schweigen zu bringen.

Das Spannungsfeld zwischen Meinungsfreiheit und Wahrheit ist dabei nicht neu. Bereits John Stuart Mill diskutierte in seinem Werk „On Liberty“ (1859) die Grenzen der freien Meinungsäußerung und argumentierte, dass auch falsche Meinungen einen Wert haben können, da sie dazu beitragen, die Wahrheit zu schärfen und zu verteidigen. In der digitalen Ära haben sich jedoch die Geschwindigkeit und Reichweite der Informationsverbreitung dramatisch verändert, was neue Überlegungen zu diesem klassischen Problem erforderlich macht.

Die vorliegende Analyse untersucht diese vielschichtigen Fragen aus verschiedenen Perspektiven. Sie beleuchtet die rechtlichen Grundlagen der Meinungsfreiheit in Deutschland und der Europäischen Union, analysiert aktuelle Regulierungsansätze wie das Netzwerkdurchsetzungsgesetz (NetzDG) und den Digital Services Act (DSA), und stellt die Argumente der verschiedenen Stakeholder gegenüber. Dabei wird deutlich, dass es keine einfachen Lösungen gibt, sondern dass ein differenzierter Ansatz erforderlich ist, der sowohl die Bedeutung der Meinungsfreiheit als auch die realen Gefahren von Desinformation ernst nimmt.

Die Relevanz dieser Debatte zeigt sich nicht zuletzt in den politischen Entwicklungen der letzten Jahre. Von der Brexit-Abstimmung über die US-Präsidentschaftswahlen bis hin zur COVID-19-Pandemie - in allen diesen Fällen spielten Desinformation und die Frage nach dem angemessenen Umgang damit eine zentrale Rolle. Die Art und Weise, wie demokratische Gesellschaften diese Herausforderung bewältigen, wird maßgeblich darüber entscheiden, wie resilient ihre demokratischen Institutionen gegenüber den Herausforderungen des digitalen Zeitalters sind.

2. Rechtliche Grundlagen der Meinungsfreiheit {#rechtliche-grundlagen}

2.1 Artikel 5 des Grundgesetzes

Die Meinungsfreiheit ist in Deutschland durch Artikel 5 Absatz 1 des Grundgesetzes geschützt, der besagt: „Jeder hat das Recht, seine Meinung in Wort, Schrift und Bild frei zu äußern und zu verbreiten und sich aus allgemein zugänglichen Quellen ungehindert zu unterrichten“ [2]. Dieses Grundrecht nimmt eine zentrale Stellung im demokratischen Verfassungsgefüge ein und wird vom Bundesverfassungsgericht als „schlechthin konstituierend“ für die freiheitliche demokratische Grundordnung bezeichnet.

Die Meinungsfreiheit hat dabei eine doppelfunktionale Struktur: Sie dient sowohl dem individuellen Schutz der Persönlichkeitsentfaltung als auch der demokratischen Funktion der freien Meinungsbildung. Diese duale Natur macht deutlich, warum Eingriffe in die Meinungsfreiheit besonders sorgfältig abgewogen werden müssen. Sie betreffen nicht nur die Rechte des Einzelnen, sondern auch das Funktionieren der Demokratie als Ganzes.

Der Schutzbereich der Meinungsfreiheit ist dabei bewusst weit gefasst. Er umfasst nicht nur wahre oder vernünftige Äußerungen, sondern grundsätzlich alle Meinungsäußerungen, unabhängig davon, ob sie als wertvoll, richtig oder gefährlich angesehen werden. Das Bundesverfassungsgericht hat wiederholt betont, dass die Meinungsfreiheit gerade auch für „störende“ und „unbequeme“ Äußerungen gilt, da diese oft besonders schutzbedürftig sind [3].

2.2 Grenzen der Meinungsfreiheit

Trotz ihrer fundamentalen Bedeutung ist die Meinungsfreiheit nicht schrankenlos gewährleistet. Artikel 5 Absatz 2 des Grundgesetzes bestimmt: „Diese Rechte finden ihre Schranken in den Vorschriften der allgemeinen Gesetze, den gesetzlichen Bestimmungen zum Schutze der Jugend und in dem Recht der persönlichen Ehre“ [4].

Die „allgemeinen Gesetze“ umfassen dabei insbesondere strafrechtliche Bestimmungen wie:

•Beleidigung (§ 185 StGB): Schutz der persönlichen Ehre vor herabsetzenden Äußerungen

•Üble Nachrede (§ 186 StGB): Verbot der Verbreitung ehrenrühriger Tatsachenbehauptungen

•Verleumdung (§ 187 StGB): Verschärfter Schutz bei wissentlich unwahren Behauptungen

•Volksverhetzung (§ 130 StGB): Schutz vor Aufstachelung zu Hass und Gewalt gegen Bevölkerungsgruppen

Besonders relevant für die Fake-News-Debatte ist die Unterscheidung zwischen Meinungsäußerungen und Tatsachenbehauptungen. Während Meinungen grundsätzlich frei geäußert werden dürfen, unterliegen Tatsachenbehauptungen strengeren Anforderungen. Unwahre Tatsachenbehauptungen genießen keinen Schutz durch die Meinungsfreiheit, wenn sie bewusst oder fahrlässig verbreitet werden und geeignet sind, rechtlich geschützte Interessen zu verletzen.

2.3 Die Abwägungslehre des Bundesverfassungsgerichts

Das Bundesverfassungsgericht hat eine differenzierte Abwägungslehre entwickelt, die bei Konflikten zwischen der Meinungsfreiheit und anderen Rechtsgütern zur Anwendung kommt. Dabei sind verschiedene Faktoren zu berücksichtigen:

Inhaltliche Kriterien:

•Unterscheidung zwischen Meinungsäußerungen und Tatsachenbehauptungen

•Wahrheitsgehalt der Äußerung

•Schwere der Rechtsgutsverletzung

•Öffentliches Interesse an der Information

Formale Kriterien:

•Art und Weise der Äußerung

•Reichweite und Verbreitungsgrad

•Kontext der Äußerung (z.B. politische Debatte)

•Möglichkeit zur Gegendarstellung

Persönliche Kriterien:

•Stellung des Äußernden (z.B. Politiker, Journalist)

•Stellung des Betroffenen (z.B. Person des öffentlichen Lebens)

•Schutzwürdigkeit der betroffenen Interessen

Diese Abwägung führt dazu, dass die Grenzen der Meinungsfreiheit nicht starr sind, sondern je nach Kontext variieren können. So genießen politische Äußerungen einen besonders hohen Schutz, während kommerzielle Äußerungen oder solche im privaten Bereich weniger geschützt sind.

2.4 Europäische und internationale Dimension

Neben dem nationalen Verfassungsrecht ist die Meinungsfreiheit auch auf europäischer und internationaler Ebene geschützt. Artikel 10 der Europäischen Menschenrechtskonvention (EMRK) gewährleistet die Meinungs- und Informationsfreiheit und ist für Deutschland völkerrechtlich bindend [5]. Die Rechtsprechung des Europäischen Gerichtshofs für Menschenrechte (EGMR) beeinflusst dabei auch die deutsche Rechtsprechung.

Artikel 11 der EU-Grundrechtecharta enthält ebenfalls eine Garantie der Meinungs- und Informationsfreiheit, die bei der Anwendung von EU-Recht zu beachten ist [6]. Dies ist besonders relevant für die aktuellen EU-weiten Regulierungsansätze wie den Digital Services Act.

2.5 Herausforderungen im digitalen Zeitalter

Die traditionellen rechtlichen Kategorien stoßen im digitalen Zeitalter an ihre Grenzen. Neue Phänomene wie algorithmische Verstärkung, Echokammern und die globale Vernetzung stellen das klassische Verständnis der Meinungsfreiheit vor Herausforderungen:

Technische Herausforderungen:

•Automatisierte Verbreitung von Inhalten

•Schwierigkeit der Zuordnung von Verantwortlichkeiten

•Grenzüberschreitende Natur digitaler Kommunikation

Rechtliche Herausforderungen:

•Anwendbarkeit nationaler Gesetze auf globale Plattformen

•Durchsetzung von Löschungsanordnungen

•Bestimmung der zuständigen Gerichte

Praktische Herausforderungen:

•Geschwindigkeit der Informationsverbreitung

•Masse der zu bewertenden Inhalte

•Schwierigkeit der Wahrheitsfindung in Echtzeit

Diese Herausforderungen haben dazu geführt, dass neue rechtliche Ansätze entwickelt wurden, die versuchen, die traditionellen Prinzipien der Meinungsfreiheit auf die digitale Welt zu übertragen. Dabei zeigt sich jedoch, dass dies nicht ohne Reibungen und Kontroversen möglich ist, wie die Debatten um das Netzwerkdurchsetzungsgesetz und den Digital Services Act verdeutlichen.

3. Das Phänomen Desinformation und Fake News {#desinformation-phaenomen}

3.1 Begriffsdefinitionen und Abgrenzungen

Um die Komplexität der Debatte zu verstehen, ist zunächst eine präzise Begriffsdefinition erforderlich. Die Begriffe „Fake News“, „Desinformation“, „Fehlinformation“ und „Malinformation“ werden oft synonym verwendet, bezeichnen jedoch unterschiedliche Phänomene mit verschiedenen Implikationen für die rechtliche und gesellschaftliche Bewertung.

Desinformation bezeichnet nach der Definition der Europäischen Kommission „nachweislich falsche oder irreführende Informationen, die mit der Absicht erstellt, präsentiert und verbreitet werden, die Öffentlichkeit zu täuschen oder einen öffentlichen Schaden zu verursachen“ [7]. Das entscheidende Element ist dabei die Absicht zur Täuschung.

Fehlinformation umfasst dagegen falsche oder irreführende Informationen, die ohne böswillige Absicht verbreitet werden. Hier liegt keine bewusste Täuschungsabsicht vor, sondern die Verbreitung erfolgt aus Unwissen oder Fahrlässigkeit.

Malinformation bezieht sich auf wahre Informationen, die jedoch in einem schädlichen Kontext geteilt werden, etwa durch selektive Darstellung oder bewusste Verzerrung des Kontexts.

Der Begriff „Fake News“ ist besonders problematisch, da er sowohl von Medien als auch von Politikern oft als politisches Kampfmittel eingesetzt wird. Wie Forschungen zeigen, wurde der Begriff zunehmend von politischen Akteuren instrumentalisiert, um unliebsame Berichterstattung zu diskreditieren [8]. Dies macht eine differenzierte Betrachtung umso wichtiger.

3.2 Erscheinungsformen und Verbreitungsmechanismen

Desinformation manifestiert sich in verschiedenen Formen, die jeweils unterschiedliche Herausforderungen für die Bekämpfung darstellen:

Vollständig erfundene Nachrichten: Komplett falsche Geschichten, die oft sensationell aufgemacht sind, um maximale Aufmerksamkeit zu erzielen. Diese sind relativ leicht zu identifizieren, haben aber oft bereits große Verbreitung gefunden, bevor sie widerlegt werden können.

Manipulierte Inhalte: Echte Informationen, die durch Weglassung, Übertreibung oder Kontextverzerrung verfälscht werden. Diese sind besonders tückisch, da sie einen wahren Kern enthalten und daher schwerer zu widerlegen sind.

Satire und Parodie: Inhalte, die ursprünglich als Humor gedacht waren, aber als echte Nachrichten missverstanden und weiterverbreitet werden. Hier liegt das Problem oft in der fehlenden Kennzeichnung oder dem Verlust des ursprünglichen Kontexts.

Propaganda und politische Manipulation: Gezielt eingesetzte Desinformation zur Beeinflussung politischer Meinungen und Wahlentscheidungen. Diese Form ist besonders problematisch für demokratische Prozesse.

Die Verbreitungsmechanismen in sozialen Medien verstärken diese Probleme erheblich. Algorithmen bevorzugen oft emotionale und kontroverse Inhalte, da diese mehr Engagement erzeugen. Eine Studie des MIT zeigte, dass falsche Nachrichten auf Twitter sechsmal schneller verbreitet werden als wahre Nachrichten und eine größere Reichweite erzielen [9].

3.3 Psychologische und gesellschaftliche Faktoren

Die Anfälligkeit für Desinformation ist nicht nur ein technisches, sondern auch ein psychologisches Problem. Verschiedene kognitive Verzerrungen begünstigen die Verbreitung falscher Informationen:

Bestätigungsfehler (Confirmation Bias): Menschen neigen dazu, Informationen zu bevorzugen, die ihre bestehenden Überzeugungen bestätigen, und widersprechende Informationen zu ignorieren oder abzuwerten.

Verfügbarkeitsheuristik: Informationen, die leicht abrufbar sind oder häufig wiederholt werden, werden als wahrer oder wichtiger eingeschätzt, unabhängig von ihrem tatsächlichen Wahrheitsgehalt.

Emotionale Verarbeitung: Emotionale Inhalte werden schneller und weniger kritisch verarbeitet als sachliche Informationen. Desinformation nutzt oft starke emotionale Trigger wie Angst, Wut oder Empörung.

Soziale Bestätigung: In sozialen Medien verstärkt sich die Wirkung durch die scheinbare Bestätigung durch andere Nutzer (Likes, Shares, Kommentare), was den Eindruck von Glaubwürdigkeit und Relevanz verstärkt.

3.4 Gesellschaftliche Auswirkungen

Die Auswirkungen von Desinformation gehen weit über die unmittelbare Verbreitung falscher Informationen hinaus und betreffen fundamentale Aspekte des gesellschaftlichen Zusammenhalts:

Vertrauensverlust in Institutionen: Systematische Desinformation untergräbt das Vertrauen in demokratische Institutionen, Medien und wissenschaftliche Expertise. Dies kann zu einer allgemeinen Skepsis gegenüber etablierten Informationsquellen führen.

Polarisierung der Gesellschaft: Desinformation verstärkt oft bestehende gesellschaftliche Spaltungen und trägt zur Bildung von „Echokammern“ bei, in denen sich Menschen nur noch mit gleichgesinnten Meinungen umgeben.

Beeinträchtigung demokratischer Prozesse: Falsche Informationen über Kandidaten, Wahlverfahren oder politische Sachverhalte können Wahlentscheidungen beeinflussen und die Legitimität demokratischer Entscheidungen in Frage stellen.

Gesundheitliche Risiken: Medizinische Desinformation, wie sie während der COVID-19-Pandemie weit verbreitet war, kann direkte gesundheitliche Schäden verursachen, wenn Menschen aufgrund falscher Informationen schädliche Entscheidungen treffen.

3.5 Akteure und Motivationen

Die Verbreitung von Desinformation erfolgt durch verschiedene Akteure mit unterschiedlichen Motivationen:

Staatliche Akteure: Regierungen nutzen Desinformation als Instrument der Außenpolitik und Einflussnahme. Beispiele sind russische Einflussoperationen in westlichen Demokratien oder chinesische Desinformationskampagnen.

Kommerzielle Akteure: Einige Akteure verbreiten Desinformation aus finanziellen Motiven, etwa durch Clickbait-Artikel, die Werbeeinnahmen generieren sollen.

Politische Akteure: Politiker und politische Organisationen nutzen manchmal bewusst falsche oder irreführende Informationen, um politische Ziele zu erreichen oder Gegner zu diskreditieren.

Ideologische Akteure: Extremistische Gruppen verbreiten Desinformation, um ihre Weltanschauung zu fördern und neue Anhänger zu gewinnen.

Unwissende Verbreiter: Ein großer Teil der Desinformationsverbreitung erfolgt durch normale Nutzer, die falsche Informationen gutgläubig weiterleiten, ohne deren Wahrheitsgehalt zu überprüfen.

3.6 Messbarkeit und Quantifizierung

Die Quantifizierung des Desinformationsproblems ist methodisch herausfordernd, aber verschiedene Studien geben Hinweise auf das Ausmaß:

Eine Studie der Reuters Institute for the Study of Journalism fand, dass 2020 etwa 25% der Menschen in verschiedenen Ländern wöchentlich auf Desinformation über COVID-19 stießen [10]. Eine andere Untersuchung zeigte, dass während der US-Präsidentschaftswahl 2020 die Top-20-Falschnachrichten auf Facebook mehr Engagement erhielten als die Top-20-Nachrichten von seriösen Nachrichtenquellen [11].

Diese Zahlen verdeutlichen, dass Desinformation kein marginales Phänomen ist, sondern ein weit verbreitetes Problem, das erhebliche gesellschaftliche Auswirkungen haben kann. Gleichzeitig zeigen sie aber auch, dass die überwiegende Mehrheit der geteilten Informationen nach wie vor aus seriösen Quellen stammt, was die Notwendigkeit einer ausgewogenen Bewertung des Problems unterstreicht.

4. Aktuelle Regulierungsansätze {#regulierungsansaetze}

4.1 Das Netzwerkdurchsetzungsgesetz (NetzDG)

Das Netzwerkdurchsetzungsgesetz, das am 1. Oktober 2017 in Kraft trat, war Deutschlands erster umfassender Versuch, die Verbreitung strafbarer Inhalte in sozialen Netzwerken zu regulieren [12]. Das Gesetz, umgangssprachlich auch „Facebook-Gesetz“ genannt, verpflichtet Anbieter sozialer Netzwerke mit mehr als zwei Millionen Nutzern zu einem strukturierten Umgang mit Nutzerbeschwerden über rechtswidrige Inhalte.

Kernbestimmungen des NetzDG:

Die zentralen Verpflichtungen umfassen ein transparentes Beschwerdemanagement, bei dem „offensichtlich rechtswidrige“ Inhalte innerhalb von 24 Stunden und alle anderen rechtswidrigen Inhalte innerhalb von sieben Tagen gelöscht oder gesperrt werden müssen. Verstöße können mit Bußgeldern von bis zu 50 Millionen Euro geahndet werden.

Das Gesetz bezieht sich dabei ausschließlich auf bereits nach deutschem Recht strafbare Inhalte, insbesondere Volksverhetzung, Beleidigung, üble Nachrede und Verleumdung. Es schafft keine neuen Straftatbestände, sondern zielt darauf ab, die Durchsetzung bestehenden Rechts zu verbessern.

Entstehungskontext und politische Motivation:

Die Entstehung des NetzDG war maßgeblich von den Erfahrungen mit Hassrede und Desinformation im Kontext der Flüchtlingskrise 2015/2016 und der US-Präsidentschaftswahl 2016 geprägt. Der damalige Justizminister Heiko Maas argumentierte, dass eine Auswertung der Löschpraxis durch „jugendschutz.net“ ergeben habe, dass nur 39 Prozent der gemeldeten Hasskommentare bei Facebook und lediglich ein Prozent bei Twitter gelöscht wurden, während YouTube eine Löschquote von 90 Prozent erreichte [13].

Kritik und verfassungsrechtliche Bedenken:

Das NetzDG war von Beginn an umstritten. Bei einer Expertenanhörung im Deutschen Bundestag äußerten acht von zehn geladenen Experten erhebliche Bedenken [14]. Die Hauptkritikpunkte umfassten:

Verfassungsrechtliche Probleme: Die Wissenschaftlichen Dienste des Deutschen Bundestages äußerten in einem Gutachten Bedenken, dass der Gesetzentwurf gegen die Verfassung und gegen Europarecht verstoße [15]. Kritiker argumentierten, dass das Gesetz eine „Privatisierung der Rechtsdurchsetzung“ bewirke, da private Unternehmen über die Rechtmäßigkeit von Äußerungen entscheiden müssten.

Overblocking-Gefahr: Experten warnten, dass Plattformen aus Furcht vor hohen Bußgeldern dazu neigen könnten, auch legale Inhalte zu löschen („Overblocking“). Der enge Zeitrahmen von 24 Stunden für „offensichtlich rechtswidrige“ Inhalte wurde als problematisch angesehen, da komplexe rechtliche Bewertungen oft mehr Zeit erfordern.

Demokratiegefährdung: Kritiker argumentierten, dass das „Löschen unter derart engem zeitlichem Druck“ selbst „demokratiegefährdend“ sei, da die Gefahr bestehe, dass Inhalte gelöscht würden, die sich später als rechtmäßig herausstellten [16].

4.2 Der Digital Services Act (DSA) der Europäischen Union

Der Digital Services Act, der am 17. Februar 2024 vollständig in Kraft trat, stellt den bisher umfassendsten Versuch dar, die digitale Kommunikation auf europäischer Ebene zu regulieren [17]. Der DSA löst teilweise das deutsche NetzDG ab und etabliert ein EU-weites Regelwerk für digitale Dienste.

Struktur und Anwendungsbereich:

Der DSA folgt einem abgestuften Ansatz, bei dem die Verpflichtungen je nach Größe und Einfluss der Plattformen variieren. Während alle digitalen Dienste grundlegenden Transparenz- und Sorgfaltspflichten unterliegen, gelten für „sehr große Online-Plattformen“ (VLOPs) mit mehr als 45 Millionen monatlichen Nutzern in der EU zusätzliche Verpflichtungen.

Zentrale Bestimmungen:

Transparenzpflichten: Plattformen müssen detaillierte Berichte über ihre Moderationspraktiken veröffentlichen und Nutzern klare Informationen über Löschentscheidungen geben.

Risikobewertung und -minderung: VLOPs müssen jährliche Risikobewertungen durchführen und Maßnahmen zur Minderung systemischer Risiken implementieren, einschließlich der Verbreitung von Desinformation.

Externe Audits: Große Plattformen unterliegen verpflichtenden externen Audits ihrer Compliance-Maßnahmen.

Forscherzugang: Qualifizierte Forscher erhalten Zugang zu Plattformdaten, um die gesellschaftlichen Auswirkungen digitaler Dienste zu untersuchen.

Unterschiede zum NetzDG:

Im Gegensatz zum NetzDG fokussiert der DSA nicht nur auf illegale Inhalte, sondern auch auf „systemische Risiken“ wie die Verbreitung von Desinformation. Der Ansatz ist präventiver und systemischer, anstatt nur reaktiv auf gemeldete Inhalte zu reagieren.

4.3 Selbstregulierungsansätze

Parallel zu den gesetzlichen Regulierungen haben sich verschiedene Selbstregulierungsansätze entwickelt, die von der Industrie selbst oder in Kooperation mit staatlichen Stellen initiiert wurden.

EU Code of Practice on Disinformation:

Der 2018 eingeführte und 2022 verschärfte Verhaltenskodex zur Bekämpfung von Desinformation ist ein freiwilliges Selbstregulierungsinstrument, dem sich große Plattformen wie Facebook, Google, Twitter und TikTok angeschlossen haben [18]. Der Kodex umfasst Verpflichtungen zur:

•Demonetarisierung von Desinformation

•Transparenz bei politischer Werbung

•Löschung gefälschter Accounts

•Zusammenarbeit mit Faktenprüfern

•Förderung von Medienkompetenz

Grenzen der Selbstregulierung:

Die Erfahrungen mit Selbstregulierungsansätzen zeigen sowohl Potentiale als auch Grenzen auf. Während Plattformen durchaus Fortschritte bei der Bekämpfung offensichtlicher Desinformation gemacht haben, bleiben Probleme bei der Transparenz und Durchsetzung bestehen. Eine Evaluierung durch die European Regulators Group for Audiovisual Media Services (ERGA) 2020 ergab, dass die von den Plattformen bereitgestellten Daten unzureichend für eine fundierte Bewertung der Umsetzung waren [19].

4.4 Internationale Vergleiche

USA: First Amendment und Marktlösungen:

Die Vereinigten Staaten verfolgen einen grundlegend anderen Ansatz, der stark vom First Amendment der US-Verfassung geprägt ist. Staatliche Regulierung von Meinungsäußerungen unterliegt dort sehr hohen verfassungsrechtlichen Hürden. Stattdessen setzt man primär auf Marktmechanismen und die Selbstregulierung der Plattformen.

Der Section 230 des Communications Decency Act gewährt Plattformen weitgehende Immunität vor Haftung für Nutzerinhalte, gibt ihnen aber gleichzeitig das Recht, Inhalte nach eigenem Ermessen zu moderieren [20]. Dieser Ansatz wird jedoch zunehmend von beiden politischen Lagern kritisiert, wenn auch aus unterschiedlichen Gründen.

Autoritäre Ansätze:

Länder wie Singapur haben mit dem „Protection from Online Falsehoods and Manipulation Act“ (POFMA) von 2019 weitreichende staatliche Befugnisse zur Bekämpfung von „Fake News“ geschaffen [21]. Diese Gesetze gewähren Regierungen die Macht, Inhalte als falsch zu klassifizieren und deren Entfernung oder Korrektur anzuordnen. Kritiker warnen, dass solche Gesetze als Instrumente der Zensur missbraucht werden können.

4.5 Bewertung der bisherigen Ansätze

Die bisherigen Regulierungsansätze zeigen sowohl Erfolge als auch Defizite auf:

Positive Entwicklungen:

•Erhöhte Transparenz bei Plattform-Moderationspraktiken

•Verbesserte Reaktionszeiten bei offensichtlich illegalen Inhalten

•Stärkung des Bewusstseins für Desinformationsprobleme

•Entwicklung technischer Lösungen zur Erkennung problematischer Inhalte

Verbleibende Herausforderungen:

•Schwierigkeit der Abgrenzung zwischen legalen und illegalen Inhalten

•Gefahr des Overblockings und der Selbstzensur

•Unzureichende Transparenz bei algorithmischen Entscheidungen

•Mangelnde Harmonisierung zwischen verschiedenen nationalen Ansätzen

•Schwierigkeit der Durchsetzung gegenüber globalen Plattformen

Die Erfahrungen zeigen, dass eine effektive Regulierung von Desinformation ein komplexes Unterfangen ist, das sowohl rechtliche als auch technische und gesellschaftliche Herausforderungen umfasst. Während die bisherigen Ansätze wichtige Fortschritte erzielt haben, bleibt die Suche nach dem optimalen Gleichgewicht zwischen Meinungsfreiheit und dem Schutz vor schädlicher Desinformation eine andauernde Aufgabe.

5. Pro-Argumente für Regulierung {#pro-argumente}

5.1 Demokratieschutz und Wahlintegrität

Das stärkste Argument für eine Regulierung von Desinformation liegt im Schutz demokratischer Prozesse. Demokratie basiert auf der Prämisse informierter Bürgerentscheidungen, die nur möglich sind, wenn Wähler Zugang zu wahrheitsgemäßen Informationen haben. Wie der Medienrechtler Rolf Schwartmann argumentiert, können Fake News „die Rechtmäßigkeit einer Wahlentscheidung beeinflussen“ [22].

Bedrohung der Wahlintegrität:

Gezielte Desinformationskampagnen können Wahlprozesse auf verschiedene Weise untergraben. Sie können falsche Informationen über Kandidaten verbreiten, Verwirrung über Wahlverfahren stiften oder das Vertrauen in die Legitimität des gesamten Wahlprozesses erschüttern. Die Erfahrungen mit ausländischen Einflussoperationen, insbesondere den russischen Aktivitäten während der US-Präsidentschaftswahl 2016, haben gezeigt, dass Desinformation als Instrument der politischen Kriegsführung eingesetzt werden kann [23].

Asymmetrische Informationskriegsführung:

Demokratische Gesellschaften sind aufgrund ihrer Offenheit und Meinungsfreiheit besonders verwundbar gegenüber Desinformationsangriffen. Während demokratische Akteure an Wahrheit und Transparenz gebunden sind, können autoritäre Akteure gezielt Falschinformationen streuen, ohne entsprechende Beschränkungen zu unterliegen. Diese Asymmetrie erfordert nach Ansicht der Befürworter regulatorische Gegenmaßnahmen.

Schutz vor Manipulation:

Eine Studie der Oxford Internet Institute dokumentierte systematische Desinformationskampagnen in über 70 Ländern, die darauf abzielen, politische Meinungen zu manipulieren [24]. Ohne angemessene Regulierung bleiben demokratische Gesellschaften diesen Manipulationsversuchen schutzlos ausgeliefert.

5.2 Medienrechtliche Verantwortung von Plattformen

Ein zentrales Argument für Regulierung liegt in der veränderten Rolle sozialer Medien im Informationsökosystem. Plattformen wie Facebook, Twitter und YouTube sind längst nicht mehr nur neutrale Infrastrukturanbieter, sondern haben sich zu zentralen Akteuren der Meinungsbildung entwickelt.

Faktische Medienunternehmen:

Soziale Netzwerke fungieren heute als de facto Medienunternehmen, die über Algorithmen entscheiden, welche Informationen Millionen von Nutzern erreichen. Wie Schwartmann betont, haben „Anbieter Sozialer Netzwerke als Medienkonzerne medienrechtliche Verantwortung“ [25]. Diese Verantwortung sollte sich auch in entsprechenden rechtlichen Verpflichtungen niederschlagen.

Kuratierung und Verstärkung:

Durch ihre Algorithmen kuratieren Plattformen aktiv Inhalte und verstärken bestimmte Nachrichten gegenüber anderen. Diese redaktionelle Funktion unterscheidet sie von reinen Telekommunikationsanbietern und rechtfertigt eine entsprechende Regulierung, ähnlich wie sie für traditionelle Medien gilt.

Marktmacht und gesellschaftlicher Einfluss:

Die enorme Marktmacht weniger großer Plattformen verleiht ihnen einen unverhältnismäßigen Einfluss auf die öffentliche Meinungsbildung. Diese Konzentration von Macht ohne entsprechende Verantwortung ist aus demokratietheoretischer Sicht problematisch und erfordert regulatorische Eingriffe.

5.3 Schutz von Persönlichkeitsrechten und Menschenwürde

Die Verbreitung von Desinformation verletzt oft nicht nur abstrakte gesellschaftliche Interessen, sondern auch konkrete Persönlichkeitsrechte einzelner Personen. Dies rechtfertigt staatliche Eingriffe zum Schutz der Betroffenen.

Verleumdung und Rufschädigung:

Falsche Tatsachenbehauptungen können den Ruf und die Lebensgrundlage von Personen zerstören. In der digitalen Welt verbreiten sich solche Verleumdungen schneller und weiter als je zuvor. Der traditionelle Rechtsschutz durch nachträgliche Klagen ist oft unzureichend, da der Schaden bereits eingetreten ist, bevor rechtliche Abhilfe möglich wird.

Hassrede und Diskriminierung:

Desinformation wird oft gezielt eingesetzt, um Hass gegen bestimmte Bevölkerungsgruppen zu schüren. Dies kann zu realer Gewalt und Diskriminierung führen, wie Beispiele aus Myanmar, Indien und anderen Ländern zeigen [26]. Der Schutz vor solchen Angriffen ist eine legitime staatliche Aufgabe.

Menschenwürde als Grenze:

Das Bundesverfassungsgericht hat wiederholt betont, dass die Menschenwürde eine absolute Grenze der Meinungsfreiheit darstellt. Desinformation, die darauf abzielt, die Würde von Personen oder Gruppen zu verletzen, verdient keinen verfassungsrechtlichen Schutz.

5.4 Marktversagen und externe Effekte

Aus ökonomischer Sicht lässt sich Regulierung mit dem Vorliegen von Marktversagen rechtfertigen. Der Markt für Informationen weist verschiedene Charakteristika auf, die eine optimale Allokation verhindern.

Negative Externalitäten:

Die Verbreitung von Desinformation erzeugt negative externe Effekte, die von den Verursachern nicht internalisiert werden. Während die Verbreiter von Falschinformationen möglicherweise Aufmerksamkeit oder finanzielle Vorteile erzielen, tragen die gesellschaftlichen Kosten (Vertrauensverlust, Polarisierung, Gesundheitsschäden) andere.

Informationsasymmetrien:

Normale Nutzer haben oft nicht die Ressourcen oder Expertise, um die Wahrheit komplexer Behauptungen zu überprüfen. Diese Informationsasymmetrie kann von böswilligen Akteuren ausgenutzt werden und rechtfertigt regulatorische Eingriffe zum Schutz der Verbraucher.

Netzwerkeffekte:

Die Verbreitung von Informationen in sozialen Netzwerken unterliegt starken Netzwerkeffekten, bei denen die Geschwindigkeit der Verbreitung wichtiger ist als die Wahrheit. Dies kann zu einer systematischen Benachteiligung wahrer gegenüber falschen Informationen führen.

5.5 Technologische Verstärkung des Problems

Die spezifischen Eigenschaften digitaler Kommunikation verstärken die Probleme von Desinformation und machen regulatorische Eingriffe notwendiger als in der analogen Welt.

Geschwindigkeit und Reichweite:

Digitale Medien ermöglichen eine beispiellose Geschwindigkeit und Reichweite der Informationsverbreitung. Eine falsche Information kann innerhalb von Stunden Millionen von Menschen erreichen, bevor Korrekturen möglich sind. Diese neue Qualität erfordert neue regulatorische Ansätze.

Algorithmische Verstärkung:

Die Algorithmen sozialer Medien sind darauf optimiert, Engagement zu maximieren, nicht Wahrheit zu fördern. Dies führt zu einer systematischen Bevorzugung emotionaler und kontroverser Inhalte, die oft falsch oder irreführend sind. Ohne regulatorische Eingriffe werden diese Verzerrungen fortbestehen.

Automatisierung und Bots:

Die Möglichkeit, Desinformation durch Bots und automatisierte Systeme zu verbreiten, schafft neue Dimensionen des Problems. Einzelne Akteure können mit geringem Aufwand massive Desinformationskampagnen durchführen, die das natürliche Gleichgewicht der öffentlichen Debatte stören.

5.6 Internationale Koordination und Wettbewerbsfähigkeit

Befürworter einer Regulierung argumentieren auch, dass unkoordinierte nationale Alleingänge ineffektiv sind und dass internationale Koordination notwendig ist.

Grenzüberschreitende Natur des Problems:

Desinformation macht nicht an nationalen Grenzen halt. Ohne internationale Koordination können Akteure einfach in Jurisdiktionen mit schwächerer Regulierung ausweichen. Dies erfordert harmonisierte Standards und Kooperationsmechanismen.

Wettbewerbsverzerrung:

Unterschiedliche regulatorische Standards können zu Wettbewerbsverzerrungen führen, bei denen Plattformen mit schwächeren Standards einen unfairen Vorteil haben. Einheitliche Mindeststandards können solche Verzerrungen verhindern.

Soft Power und Normensetzung:

Durch die Entwicklung effektiver Regulierungsansätze können demokratische Länder internationale Normen setzen und ihre Werte in der digitalen Welt durchsetzen. Dies ist besonders wichtig angesichts der Konkurrenz mit autoritären Modellen der Internetregulierung.

5.7 Präventiver Ansatz und Systemschutz

Schließlich argumentieren Befürworter, dass ein präventiver Ansatz notwendig ist, um systemische Schäden zu verhindern, bevor sie eintreten.

Systemische Risiken:

Desinformation kann systemische Risiken für die Gesellschaft schaffen, die über einzelne falsche Nachrichten hinausgehen. Dazu gehören die Untergrabung des Vertrauens in Institutionen, die Polarisierung der Gesellschaft und die Schwächung der demokratischen Kultur.

Irreversible Schäden:

Einige durch Desinformation verursachte Schäden sind irreversibel oder nur schwer rückgängig zu machen. Beispiele sind Gewalt gegen Minderheiten, die durch Hassrede angestachelt wurde, oder Gesundheitsschäden durch medizinische Falschinformationen. Ein präventiver Ansatz ist daher gerechtfertigt.

Resilienz der Demokratie:

Demokratische Systeme müssen resilient gegenüber Angriffen auf ihre Grundlagen sein. Dies erfordert proaktive Maßnahmen zum Schutz der Informationsintegrität, ähnlich wie andere kritische Infrastrukturen geschützt werden.

Diese Argumente zeigen, dass die Befürworter einer Regulierung von Desinformation nicht primär die Meinungsfreiheit einschränken wollen, sondern vielmehr die Voraussetzungen für eine funktionierende demokratische Meinungsbildung schützen möchten. Sie argumentieren, dass ohne angemessene Regulierung die Meinungsfreiheit selbst bedroht ist, da sie durch Manipulation und Desinformation untergraben wird.

6. Contra-Argumente gegen Regulierung {#contra-argumente}

6.1 Fundamentale Bedeutung der Meinungsfreiheit

Das stärkste Argument gegen eine weitreichende Regulierung von Desinformation liegt in der fundamentalen Bedeutung der Meinungsfreiheit für demokratische Gesellschaften. Kritiker warnen, dass gut gemeinte Gesetze gegen „Fake News“ die Grundlagen der freien Meinungsäußerung untergraben können.

Toleranz für unliebsame Meinungen:

Wie der Berliner Medienrechtsanwalt Dominik Höch argumentiert: „Wir müssen leider - so bitter das ist - auch ausländerfeindliche Meinungen aushalten, solange sie rechtlich nicht angreifbar sind“ [27]. Diese Toleranz für störende und unbequeme Meinungen ist ein Kernprinzip liberaler Demokratien, das nicht leichtfertig aufgegeben werden sollte.

Historische Erfahrungen mit Zensur:

Die Geschichte zeigt, dass staatliche Befugnisse zur Kontrolle von Informationen regelmäßig missbraucht werden. Was heute als „Fake News“ klassifiziert wird, kann morgen als unbequeme Wahrheit entlarvt werden. Die Erfahrungen mit autoritären Regimen mahnen zur Vorsicht bei der Übertragung von Wahrheitsdefinitionen an staatliche Stellen.

Meinungsfreiheit als Prozess:

John Stuart Mills klassisches Argument aus „On Liberty“ behält auch im digitalen Zeitalter seine Gültigkeit: Der freie Wettstreit der Ideen, einschließlich falscher Ideen, ist notwendig, um die Wahrheit zu schärfen und lebendig zu halten. Selbst falsche Meinungen können wertvoll sein, da sie dazu zwingen, die eigenen Überzeugungen zu überdenken und zu begründen.

6.2 Praktische Probleme der Wahrheitsfindung

Ein zentrales Problem jeder Regulierung von „Fake News“ liegt in der praktischen Schwierigkeit, Wahrheit von Falschheit zu unterscheiden, insbesondere unter Zeitdruck.

Komplexität der Wahrheitsfindung:

Wie Höch betont, ist es „unter Umständen sehr schwierig, zu beurteilen, ob eine Behauptung falsch oder richtig sei“ [28]. Viele Aussagen bewegen sich in Grauzonen, sind teilweise wahr oder hängen von der Interpretation ab. Die pauschale Forderung an Plattformen, Beiträge innerhalb von 24 Stunden zu bewerten, ist daher „vermessen“.

Kontextabhängigkeit von Wahrheit:

Wahrheit ist oft kontextabhängig und kann sich mit neuen Erkenntnissen ändern. Was heute als wissenschaftlicher Konsens gilt, kann morgen widerlegt werden. Die COVID-19-Pandemie lieferte zahlreiche Beispiele dafür, wie sich offizielle Empfehlungen und wissenschaftliche Erkenntnisse im Laufe der Zeit änderten.

Gefahr nachträglicher Korrekturen:

Besonders problematisch ist die Gefahr, dass Inhalte gelöscht werden, die sich später als wahr herausstellen. Wie Höch warnt, wäre es „wirklich gefährlich für die Meinungsfreiheit, wenn Inhalte gelöscht würden, die sich später als wahr herausstellten“ [29]. Solche Fehlentscheidungen können das Vertrauen in die Regulierung und die Plattformen nachhaltig beschädigen.

6.3 Overblocking und Chilling Effects

Eine der Hauptsorgen der Kritiker ist die Gefahr des „Overblockings“ - der übermäßigen Löschung auch legaler Inhalte aus Vorsicht vor rechtlichen Konsequenzen.

Anreize zur Übervorsicht:

Angesichts hoher Bußgelder haben Plattformen starke Anreize, im Zweifel eher zu viel als zu wenig zu löschen. Wie der Münsteraner Professor Bernd Holznagel warnte, könnten Netzwerke „dazu neigen, auch legale Beiträge zu löschen“, um hohen Bußgeldzahlungen zu entgehen [30].

Automatisierte Entscheidungen:

Der Zeitdruck und die Masse der zu bewertenden Inhalte führen dazu, dass Plattformen zunehmend auf automatisierte Systeme setzen. Diese sind jedoch notorisch unzuverlässig bei der Bewertung von Kontext, Ironie oder komplexen Sachverhalten, was zu systematischen Fehlentscheidungen führt.

Selbstzensur der Nutzer:

Die Unsicherheit über die Grenzen des Erlaubten kann zu Selbstzensur führen, bei der Nutzer aus Furcht vor Konsequenzen auf legitime Meinungsäußerungen verzichten. Dieser „Chilling Effect“ kann die Meinungsvielfalt erheblich beeinträchtigen, ohne dass dies in offiziellen Statistiken sichtbar wird.

6.4 Privatisierung der Rechtsdurchsetzung

Ein fundamentaler verfassungsrechtlicher Einwand gegen die aktuelle Regulierung liegt in der Übertragung hoheitlicher Aufgaben an private Unternehmen.

Demokratische Legitimation:

Die Entscheidung über die Grenzen der Meinungsfreiheit ist eine genuin staatliche Aufgabe, die demokratische Legitimation erfordert. Private Unternehmen, die primär ihren Aktionären verpflichtet sind, sollten nicht über grundrechtlich geschützte Äußerungen entscheiden müssen.

Fehlende Verfahrensgarantien:

Gerichtliche Verfahren bieten umfassende Verfahrensgarantien wie das Recht auf Anhörung, Beweiswürdigung und Berufung. Diese Garantien fehlen bei der Moderation durch private Plattformen weitgehend, was zu willkürlichen Entscheidungen führen kann.

Interessenkonflikte:

Plattformen haben eigene kommerzielle Interessen, die mit einer objektiven Bewertung von Inhalten kollidieren können. Sie könnten beispielsweise Inhalte bevorzugen, die mehr Engagement erzeugen, oder solche benachteiligen, die ihren Geschäftspartnern schaden.

6.5 Alternative Mechanismen des Marktversagens

Kritiker argumentieren, dass der Markt für Informationen durchaus funktionsfähige Korrekturmechanismen besitzt, die staatliche Eingriffe überflüssig machen.

Kritische Öffentlichkeit:

Wie Höch betont, sind „alle Inhalte im Internet, die rechtlich verboten seien, ansonsten Gegenstand einer wachen und kritischen Öffentlichkeit“, die er „in Deutschland zurzeit gegeben“ sieht [31]. Diese zivilgesellschaftliche Kontrolle kann effektiver sein als staatliche Regulierung.

Faktenchecking und Journalismus:

Professionelle Medien und Faktenchecker spielen eine wichtige Rolle bei der Aufdeckung und Korrektur von Falschinformationen. Diese Mechanismen funktionieren „im Schnitt ganz gut“ und können durch Förderung und Stärkung verbessert werden, ohne die Meinungsfreiheit zu beschränken.

Technologische Lösungen:

Technologische Innovationen wie verbesserte Algorithmen, Nutzer-Bewertungssysteme oder Blockchain-basierte Verifikationssysteme können zur Lösung des Problems beitragen, ohne staatliche Eingriffe zu erfordern.

6.6 Verfassungsrechtliche und rechtsstaatliche Bedenken

Juristen haben verschiedene verfassungsrechtliche Einwände gegen die aktuelle Regulierung vorgebracht.

Bestimmtheitsgrundsatz:

Gesetze müssen hinreichend bestimmt sein, damit Bürger ihr Verhalten danach ausrichten können. Begriffe wie „offensichtlich rechtswidrig“ oder „Fake News“ sind jedoch oft zu unbestimmt, um als Grundlage für Sanktionen zu dienen.

Verhältnismäßigkeit:

Kritiker bezweifeln, ob die drastischen Sanktionen des NetzDG verhältnismäßig sind. Bußgelder von bis zu 50 Millionen Euro für Verfahrensfehler erscheinen überzogen und können zu unverhältnismäßigen Reaktionen führen.

Gewaltenteilung:

Die Übertragung quasi-richterlicher Funktionen an private Unternehmen verletzt nach Ansicht einiger Kritiker das Prinzip der Gewaltenteilung, da Rechtsprechung eine originär staatliche Aufgabe ist.

6.7 Internationale Erfahrungen und Missbrauchsrisiken

Die internationale Erfahrung zeigt, dass „Anti-Fake-News-Gesetze“ häufig für politische Zensur missbraucht werden.

Autoritäre Instrumentalisierung:

Länder wie Singapur, Malaysia oder die Türkei haben „Fake News“-Gesetze genutzt, um kritische Berichterstattung zu unterdrücken und politische Opposition zum Schweigen zu bringen [32]. Diese Beispiele zeigen das Missbrauchspotential solcher Gesetze.

Normative Ausstrahlung:

Auch demokratische Länder können durch ihre Regulierung autoritären Regimen Legitimation für deren Zensurmaßnahmen liefern. Wenn Deutschland oder die EU „Fake News“ regulieren, können autoritäre Regime dies als Rechtfertigung für ihre eigenen, weitreichenderen Maßnahmen anführen.

Slippery Slope-Argument:

Kritiker warnen vor einem „Dammbruch“: Was mit der Regulierung offensichtlicher Falschinformationen beginnt, kann sich schrittweise auf immer weitere Bereiche ausdehnen, bis schließlich jede unbequeme Meinung als „Desinformation“ klassifiziert werden kann.

6.8 Effektivitätszweifel

Schließlich bezweifeln Kritiker, ob Regulierung überhaupt effektiv zur Lösung des Problems beitragen kann.

Whack-a-Mole-Problem:

Das Löschen von Inhalten führt oft nur dazu, dass sie an anderer Stelle wieder auftauchen. Ohne Adressierung der Ursachen von Desinformation bleibt die Regulierung symptomatisch.

Streisand-Effekt:

Zensurmaßnahmen können paradoxerweise dazu führen, dass zensierte Inhalte mehr Aufmerksamkeit erhalten, als sie ohne Zensur bekommen hätten. Dies kann die Verbreitung von Desinformation sogar verstärken.

Technische Umgehung:

Technisch versierte Akteure können Regulierungsmaßnahmen durch Verschlüsselung, dezentrale Plattformen oder andere technische Mittel umgehen, während normale Nutzer von den Beschränkungen betroffen bleiben.

6.9 Bessere Alternativen

Statt staatlicher Regulierung schlagen Kritiker alternative Ansätze vor:

Medienkompetenz:

Bildung und Medienkompetenz können Bürgern helfen, Desinformation selbst zu erkennen und zu bewerten. Dies stärkt die demokratische Kultur, ohne die Meinungsfreiheit zu beschränken.

Transparenz und Aufklärung:

Mehr Transparenz über die Funktionsweise von Algorithmen und die Finanzierung von Inhalten kann Nutzern helfen, informierte Entscheidungen zu treffen.

Zivilrechtliche Durchsetzung:

Bestehende zivilrechtliche Instrumente wie Unterlassungsansprüche und Schadensersatz können gestärkt werden, ohne neue staatliche Befugnisse zu schaffen.

Marktbasierte Lösungen:

Wettbewerb zwischen Plattformen kann zu besseren Moderationspraktiken führen, wenn Nutzer Plattformen mit schlechter Moderation verlassen.

Diese Argumente zeigen, dass die Kritiker der Regulierung nicht gleichgültig gegenüber dem Problem der Desinformation sind, sondern alternative Lösungsansätze bevorzugen, die die Meinungsfreiheit weniger beeinträchtigen. Sie argumentieren, dass die Heilung nicht schlimmer sein darf als die Krankheit und dass der Schutz der Meinungsfreiheit langfristig wichtiger ist als der kurzfristige Schutz vor Desinformation.

7. Internationale Vergleiche {#internationale-vergleiche}

7.1 USA: First Amendment und Marktlösungen

Die Vereinigten Staaten verfolgen einen grundlegend anderen Ansatz als Europa. Das First Amendment der US-Verfassung gewährt einen sehr starken Schutz der Meinungsfreiheit, der staatliche Eingriffe in die Meinungsäußerung stark beschränkt. Wie ein Reddit-Nutzer treffend formulierte: „The first amendment doesn’t give us free speech. The first amendment prohibits congress from limiting free speech“ [33].

Section 230 des Communications Decency Act gewährt Plattformen weitgehende Immunität vor Haftung für Nutzerinhalte, erlaubt ihnen aber gleichzeitig, Inhalte nach eigenem Ermessen zu moderieren. Dieser Ansatz wird jedoch zunehmend von beiden politischen Lagern kritisiert - Konservative beklagen Zensur, Liberale fordern mehr Verantwortung der Plattformen.

7.2 Autoritäre Ansätze

Länder wie Singapur haben mit dem „Protection from Online Falsehoods and Manipulation Act“ (POFMA) weitreichende staatliche Befugnisse geschaffen. Seit 2019 kann die Regierung Inhalte als falsch klassifizieren und deren Entfernung oder Korrektur anordnen [34]. Kritiker warnen vor dem Missbrauchspotential solcher Gesetze für politische Zensur.

7.3 Europäischer Mittelweg

Der europäische Ansatz versucht einen Mittelweg zwischen amerikanischer Zurückhaltung und autoritärer Kontrolle zu finden. Der Digital Services Act etabliert ein System abgestufter Verantwortlichkeiten, das sowohl Meinungsfreiheit als auch Schutz vor Schäden berücksichtigt.

8. Praktische Herausforderungen {#praktische-herausforderungen}

8.1 Technische Grenzen

Die automatisierte Erkennung von Desinformation stößt an technische Grenzen. Algorithmen haben Schwierigkeiten mit Kontext, Ironie, kulturellen Nuancen und sich entwickelnden Narrativen. Dies führt zu hohen Fehlerquoten bei automatisierten Entscheidungen.

8.2 Skalierungsprobleme

Die schiere Menge der täglich veröffentlichten Inhalte macht eine manuelle Überprüfung unmöglich. Facebook allein verarbeitet täglich Milliarden von Posts, was eine vollständige menschliche Moderation ausschließt.

8.3 Kulturelle und sprachliche Barrieren

Globale Plattformen müssen mit verschiedenen Kulturen, Sprachen und Rechtssystemen umgehen. Was in einem Land als akzeptabel gilt, kann in einem anderen illegal sein. Diese Komplexität erschwert einheitliche Moderationsstandards.

8.4 Grenzüberschreitende Durchsetzung

Die globale Natur des Internets macht die Durchsetzung nationaler Gesetze schwierig. Inhalte können von Servern in anderen Ländern stammen, und Nutzer können technische Mittel zur Umgehung von Beschränkungen einsetzen.

9. Lösungsansätze und Empfehlungen {#loesungsansaetze}

9.1 Mehrebenen-Ansatz

Eine effektive Bekämpfung von Desinformation erfordert einen Mehrebenen-Ansatz, der verschiedene Instrumente kombiniert:

Rechtliche Ebene:

•Präzise Definition von Begriffen und Tatbeständen

•Verhältnismäßige Sanktionen

•Verfahrensgarantien und Rechtsschutz

•Internationale Kooperation

Technische Ebene:

•Verbesserte Algorithmen zur Erkennung problematischer Inhalte

•Transparenz über Funktionsweise von Empfehlungssystemen

•Nutzerfreundliche Melde- und Bewertungssysteme

•Interoperabilität zwischen Plattformen

Gesellschaftliche Ebene:

•Förderung von Medienkompetenz

•Stärkung des Qualitätsjournalismus

•Unterstützung von Faktencheckern

•Zivilgesellschaftliche Initiativen

9.2 Abgestufte Regulierung

Statt pauschaler Verbote sollte eine abgestufte Regulierung verschiedene Arten von Inhalten unterschiedlich behandeln:

Illegale Inhalte: Schnelle Entfernung bei eindeutig strafbaren Inhalten Schädliche Inhalte: Reduzierte Reichweite und Warnhinweise Umstrittene Inhalte: Kennzeichnung und Kontextualisierung Legitime Meinungen: Vollständiger Schutz, auch wenn sie unpopulär sind

9.3 Transparenz und Rechenschaftspflicht

Plattformen sollten zu mehr Transparenz verpflichtet werden:

•Veröffentlichung von Moderationsrichtlinien

•Regelmäßige Transparenzberichte

•Externe Audits

•Zugang für Forscher

9.4 Stärkung der Nutzer

Nutzer sollten mehr Kontrolle über ihre Informationsumgebung erhalten:

•Wahlmöglichkeiten bei Algorithmen

•Bessere Werkzeuge zur Quellenverifikation

•Bildungsprogramme zur Medienkompetenz

•Einfache Melde- und Korrekturmechanismen

10. Fazit und Ausblick {#fazit}

Das Spannungsfeld zwischen Meinungsfreiheit und dem Kampf gegen Desinformation gehört zu den komplexesten Herausforderungen demokratischer Gesellschaften im digitalen Zeitalter. Die vorliegende Analyse zeigt, dass es keine einfachen Antworten gibt und dass sowohl die Befürworter als auch die Kritiker einer Regulierung berechtigte Anliegen vorbringen.

10.1 Zentrale Erkenntnisse

Komplexität des Problems: Desinformation ist kein monolithisches Phänomen, sondern umfasst verschiedene Arten von Inhalten mit unterschiedlichen Motivationen und Auswirkungen. Dies erfordert differenzierte Lösungsansätze statt pauschaler Verbote.

Grenzen der Regulierung: Staatliche Regulierung kann wichtige Beiträge zur Bekämpfung von Desinformation leisten, stößt aber an praktische und verfassungsrechtliche Grenzen. Overblocking und Chilling Effects sind reale Risiken, die ernst genommen werden müssen.

Notwendigkeit eines Mehrebenen-Ansatzes: Keine einzelne Maßnahme kann das Problem vollständig lösen. Erforderlich ist eine Kombination aus rechtlichen, technischen und gesellschaftlichen Ansätzen.

Bedeutung der Medienkompetenz: Langfristig ist die Stärkung der Medienkompetenz der Bürger wichtiger als staatliche Zensur. Nur informierte und kritische Bürger können eine resiliente Demokratie aufrechterhalten.

10.2 Empfehlungen

Basierend auf der Analyse lassen sich folgende Empfehlungen ableiten:

1.Präzisierung der Rechtslage: Begriffe wie „Fake News“ sollten durch präzise rechtliche Definitionen ersetzt werden, die zwischen verschiedenen Arten problematischer Inhalte unterscheiden.

2.Stärkung der Verfahrensgarantien: Bei der Moderation von Inhalten müssen rechtsstaatliche Prinzipien wie Anhörungsrechte und Rechtsmittel gewährleistet werden.

3.Förderung der Transparenz: Plattformen sollten zu mehr Transparenz über ihre Moderationspraktiken und Algorithmen verpflichtet werden.

4.Investition in Bildung: Massive Investitionen in Medienkompetenz und kritisches Denken sind notwendig, um die Gesellschaft resilient gegen Desinformation zu machen.

5.Internationale Kooperation: Das grenzüberschreitende Problem der Desinformation erfordert verstärkte internationale Zusammenarbeit und harmonisierte Standards.

10.3 Ausblick

Die Debatte über Meinungsfreiheit und Desinformation wird sich mit der weiteren technologischen Entwicklung intensivieren. Neue Technologien wie Künstliche Intelligenz, Deepfakes und das Metaverse werden neue Herausforderungen schaffen, die innovative Lösungsansätze erfordern.

Gleichzeitig zeigen die Erfahrungen der letzten Jahre, dass sowohl unregulierte Desinformation als auch übermäßige Zensur demokratische Gesellschaften bedrohen können. Der Schlüssel liegt in der Findung eines ausgewogenen Ansatzes, der die Meinungsfreiheit als Grundpfeiler der Demokratie respektiert, gleichzeitig aber auch die realen Gefahren von Desinformation ernst nimmt.

Die Zukunft der Demokratie im digitalen Zeitalter hängt davon ab, ob es gelingt, dieses Gleichgewicht zu finden und aufrechtzuerhalten. Dies erfordert einen kontinuierlichen Dialog zwischen allen Stakeholdern - Regierungen, Plattformen, Zivilgesellschaft und Bürgern - sowie die Bereitschaft, Ansätze anzupassen, wenn sich neue Erkenntnisse ergeben.

Letztendlich ist der Kampf gegen Desinformation nicht nur ein technisches oder rechtliches Problem, sondern eine Frage der demokratischen Kultur. Eine Gesellschaft, die kritisches Denken fördert, Vielfalt respektiert und den offenen Dialog pflegt, wird resistenter gegen Desinformation sein als eine, die primär auf Zensur und Kontrolle setzt. In diesem Sinne ist die Stärkung der Meinungsfreiheit und die Bekämpfung von Desinformation kein Widerspruch, sondern zwei Seiten derselben Medaille: dem Schutz und der Förderung einer lebendigen demokratischen Kultur.

11. Quellen {#quellen}

[1] Konrad-Adenauer-Stiftung: „Meinungsfreiheit stärken - Desinformation abgestuft regulieren“ (2021). https://www.kas.de/de/web/auslandsinformationen/artikel/detail/-/content/meinungsfreiheit-staerken-desinformation-abgestuft-regulieren

[2] Grundgesetz für die Bundesrepublik Deutschland, Artikel 5. https://www.gesetze-im-internet.de/gg/art_5.html

[3] Bundeszentrale für politische Bildung: „Meinungsfreiheit und ihre Grenzen“ (2020). https://www.bpb.de/shop/zeitschriften/apuz/306444/meinungsfreiheit-und-ihre-grenzen/

[4] Grundgesetz für die Bundesrepublik Deutschland, Artikel 5 Absatz 2. https://www.gesetze-im-internet.de/gg/art_5.html

[5] Europäische Menschenrechtskonvention, Artikel 10. https://www.echr.coe.int/documents/convention_deu.pdf

[6] Charta der Grundrechte der Europäischen Union, Artikel 11. https://eur-lex.europa.eu/legal-content/DE/TXT/?uri=CELEX:12012P/TXT

[7] Europäische Kommission: „Bekämpfung von Desinformation im Internet“. https://digital-strategy.ec.europa.eu/de/policies/online-disinformation

[8] ResearchGate: „How to hijack a discourse? Reflections on the concepts of post-truth and fake news“. https://www.researchgate.net/publication/342938662_How_to_hijack_a_discourse_Reflections_on_the_concepts_of_post-truth_and_fake_news

[9] MIT Technology Review: „The science of fake news“ (2018).

[10] Reuters Institute for the Study of Journalism: „COVID-19 Misinformation Study“ (2020).

[11] New York University: „Facebook Engagement Study“ (2020).

[12] Netzwerkdurchsetzungsgesetz (NetzDG). https://www.gesetze-im-internet.de/netzdg/

[13] Bundestag: „Bundestag beschließt Gesetz gegen strafbare Inhalte im Internet“ (2017). https://www.bundestag.de/webarchiv/textarchiv/2017/kw26-de-netzwerkdurchsetzungsgesetz-513398

[14] Wikipedia: „Netzwerkdurchsetzungsgesetz“. https://de.wikipedia.org/wiki/Netzwerkdurchsetzungsgesetz

[15] Wissenschaftliche Dienste des Deutschen Bundestages: Gutachten zum NetzDG (2016).

[16] Berliner Morgenpost: „Pro und Kontra: Brauchen wir mehr Gesetze gegen Fake News?“ (2017). https://www.morgenpost.de/politik/article401889274/pro-und-kontra-brauchen-wir-mehr-gesetze-gegen-fake-news.html

[17] Europäische Kommission: „The EU’s Digital Services Act“. https://commission.europa.eu/strategy-and-policy/priorities-2019-2024/europe-fit-digital-age/digital-services-act_en

[18] Europäische Kommission: „EU-Verhaltenskodex zur Bekämpfung von Desinformation“. https://commission.europa.eu/strategy-and-policy/priorities-2019-2024/new-push-european-democracy/protecting-democracy/strengthened-eu-code-practice-disinformation_de

[19] European Regulators Group for Audiovisual Media Services (ERGA): „Report on disinformation“ (2020).

[20] Electronic Frontier Foundation: „Section 230 of the Communications Decency Act“.

[21] Pew Research Center: „Widespread global public concern about made-up news“ (2025). https://www.pewresearch.org/global/2025/04/24/widespread-global-public-concern-about-made-up-news/

[22] Berliner Morgenpost: „Pro und Kontra: Brauchen wir mehr Gesetze gegen Fake News?“ (2017).

[23] Oxford Internet Institute: „Computational Propaganda Research Project“.

[24] Oxford Internet Institute: „Global Inventory of Organised Social Media Manipulation“ (2021).

[25] Berliner Morgenpost: „Pro und Kontra: Brauchen wir mehr Gesetze gegen Fake News?“ (2017).

[26] Reuters: „Facebook hate speech in Myanmar“ (2018).

[27] Berliner Morgenpost: „Pro und Kontra: Brauchen wir mehr Gesetze gegen Fake News?“ (2017).

[28] Berliner Morgenpost: „Pro und Kontra: Brauchen wir mehr Gesetze gegen Fake News?“ (2017).

[29] Berliner Morgenpost: „Pro und Kontra: Brauchen wir mehr Gesetze gegen Fake News?“ (2017).

[30] Wikipedia: „Netzwerkdurchsetzungsgesetz“.

[31] Berliner Morgenpost: „Pro und Kontra: Brauchen wir mehr Gesetze gegen Fake News?“ (2017).

[32] Freedom House: „Freedom on the Net Report“ (2023).

[33] Reddit: „What makes free speech in the US different from free speech in other countries?“ (2024). https://www.reddit.com/r/AskAnAmerican/comments/1c784fp/what_makes_free_speech_in_the_us_different_from/

[34] Pew Research Center: „Widespread global public concern about made-up news“ (2025).

Über den Autor:

Diese Analyse wurde von Manus AI erstellt, einem autonomen KI-System, das darauf spezialisiert ist, komplexe gesellschaftliche und rechtliche Fragestellungen zu untersuchen und ausgewogene Analysen zu erstellen.

Haftungsausschluss:

Diese Analyse dient ausschließlich Informationszwecken und stellt keine Rechtsberatung dar. Für spezifische rechtliche Fragen sollten qualifizierte Rechtsanwälte konsultiert werd