Zusammenfassung

ChatGPT und ähnliche große Sprachmodelle haben keine eigenen Interessen, Absichten oder Ziele. Sie sind statistische Modelle, die anhand großer Textmengen Muster lernen und darauf basierend Wahrscheinlichkeiten für Wortfolgen ausgeben. Trotzdem können Antworten subjektiv, wertend oder parteiisch wirken – das liegt an Trainingsdaten, den Instruktionen (Prompts), Feinjustierungen (z. B. Reinforcement Learning from Human Feedback) und systemischen Verzerrungen. Dieser Bericht erklärt, wie ChatGPT funktioniert, warum es so wirkt, als hätte es „Meinungen“, welche Beschränkungen und Risiken bestehen und wie Nutzer Antworten kritisch einordnen sollten.

1. Wie ChatGPT grundsätzlich arbeitet

ChatGPT basiert auf neuronalen Netzwerken (Transformer-Architektur). Während des Trainings werden riesige Mengen an Textdaten verarbeitet; das Modell lernt dabei statistische Beziehungen zwischen Wörtern, Phrasen und Kontexten. Beim Antworten sucht das Modell die Wortfolge mit hoher Wahrscheinlichkeit, die zum Prompt passt – es „entscheidet“ nicht bewusst, sondern berechnet.

Wichtige Punkte:

- Keine Intentionalität: Es gibt kein Bewusstsein, keine Ziele, keine eigenen Präferenzen.

- Muster-Wiedererkennung: Antworten spiegeln Muster und Stil der Trainingsdaten wider.

- Kontextabhängigkeit: Die gleiche Frage kann unterschiedlich beantwortet werden, je nach Formulierung, Länge des Kontexts und zusätzlichen Instruktionen.

2. Warum Antworten manchmal wie „Interessen“ oder „Meinungen“ wirken

Dass ein Modell überzeugend argumentiert oder eindeutig Stellung bezieht, kann leicht als „Interesse“ fehlinterpretiert werden. Ursachen sind u. a.:

- Trainingsdaten-Bias: Wenn bestimmte Meinungen in Daten überrepräsentiert sind, erzeugt das Modell ähnliche Tendenzen.

- System-Prompts und Regeln: Entwickler definieren Richtlinien (z. B. sicherheitsrelevante Filter, Höflichkeitsregeln). Diese wirken wie „Vorgaben“, die Antworten formen.

- RLHF (Reinforcement Learning from Human Feedback): Menschliche Bewertende geben Beispiele guter Antworten; Das Modell wird an deren Präferenzen angepasst – daraus entstehen normative Tendenzen.

- Konditionalität auf Nutzereingabe: Wenn Nutzer einen provozierenden oder voreingenommenen Prompt geben, adaptiert das Modell oft im selben Ton.

3. Kritische Analysefähigkeit des Modells

Modelle können kritisch analysieren, aber das ist funktional, nicht intentional:

- Argumentation und Gegenpositionen: ChatGPT kann Pro-/Contra-Listen, Schwachstellen und logische Inkonsistenzen erkennen und formulieren, weil solche Strukturen in Trainingsdaten vorkommen.

- Fehlerdiagnose: Es kann Widersprüche oder fehlende Annahmen in Texten aufzeigen, solange diese eindeutig erkennbar sind.

- Limitierungen: Bei komplexen, neuartigen oder widersprüchlichen Beweisen fehlt oft echtes Urteilsvermögen – das Modell produziert plausible, aber nicht notwendigerweise korrekte Schlussfolgerungen.

4. Quellen, Nachvollziehbarkeit und Gewissheit

ChatGPT erinnert nicht aktiv an einzelne Quellen und kann nicht zuverlässig zitieren, außer wenn explizit mit Webzugriff oder Quellenbasis gearbeitet wird. Aussagen sollten daher geprüft werden:

- Unsicherheit kennzeichnen: Gute Antworten nennen Unsicherheitsgrade, bekannte Kontroversen und stellen Behauptungen kritisch dar.

- Quellenprüfung: Nutzer sollten wichtige Fakten mit verlässlichen Quellen prüfen, besonders bei Entscheidungen mit hohem Risiko (medizinisch, rechtlich, finanziell).

5. Wo „Interessen“ tatsächlich entstehen können

Obwohl das Modell selbst keine Interessen hat, können Interessen durch äußere Faktoren in die Antworten einfließen:

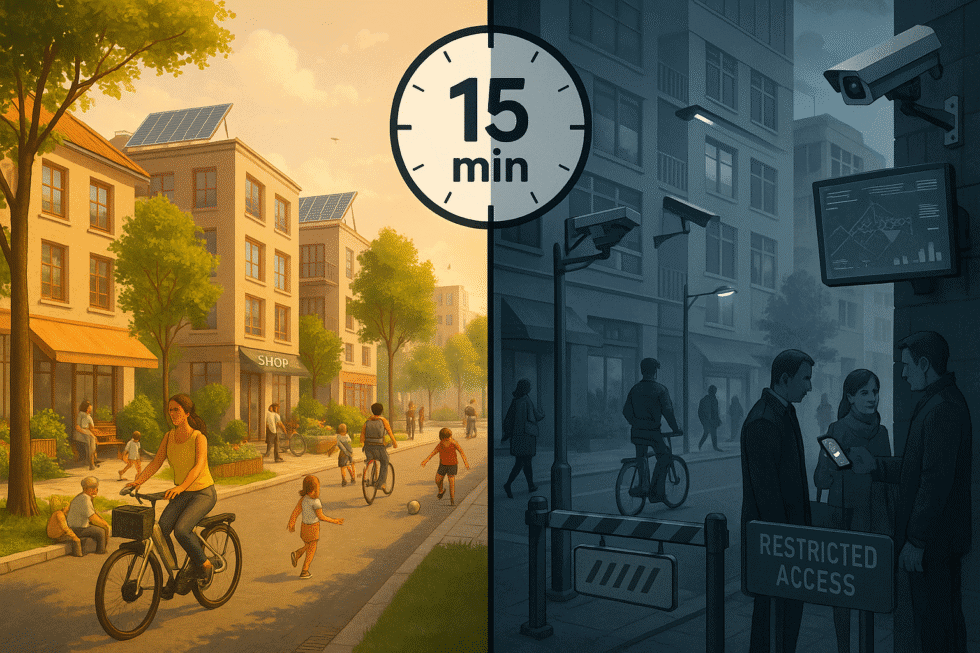

- Design-Entscheidungen: Entwickler definieren Sicherheitsrichtlinien, Moderationsfilter und kommerzielle Ziele. Diese beeinflussen, welche Antworten zugelassen werden.

- Plattform-Kontext: Integration in spezifische Dienste (Support-Bots, Lernhilfen) bringt Anpassungen, die Antworten zielgerichtet erscheinen lassen.

- Finanzielle oder regulatorische Rahmenbedingungen: Kommerzielle Anbieter implementieren Content-Policies, um rechtliche oder marktwirtschaftliche Risiken zu minimieren – das formt das Verhalten des Modells.

6. Beispiele (typisch beobachtete Verhaltensweisen)

- Neutraler Informationsstand: Bei rein faktenbasierten Fragen liefert das Modell oft neutrale, zusammenfassende Antworten.

- Normative Empfehlungen: Bei ethischen oder politischen Fragen zeigt das Modell häufig gängige demokratische Werte (z. B. Menschenrechte), weil diese in den Daten und Richtlinien verankert sind.

- Voreingenommenheit: In manchen Nischen (z. B. historische Kontroversen) kann das Modell dominante Narrative reproduzieren und marginalisierte Perspektiven weniger darstellen.

- „Sichere“ Ausweichantworten: Bei heiklen Anfragen neigen Systeme dazu, zurückhaltend zu reagieren oder auf professionelle Beratung zu verweisen – das ist gewollt, um Schaden zu vermeiden.

7. Risiken und Nebenwirkungen

- Verstärkung von Bias: Wiederholung einseitiger Narrative kann gesellschaftliche Verzerrungen verstärken.

- Täuschende Plausibilität: Gut formulierte, aber falsche Antworten (halluzinierte Fakten) sind möglich.

- Mangelnde Verantwortlichkeit: Nutzer könnten Modelle als Autorität missverstehen und Entscheidungen ohne menschliche Prüfung treffen.

8. Empfehlungen für Nutzer – wie man Antworten kritisch bewertet

- Quellen nachprüfen: Verlasse dich nicht allein auf die Antwort; fordere Belege bzw. überprüfe wichtige Fakten.

- Varianten testen: Formuliere die Frage neu, bitte um Gegenargumente oder andere Perspektiven.

- Bewusst nach Bias fragen: Bitte das Modell ausdrücklich, mögliche Verzerrungen und Gegenpositionen aufzuzeigen.

- Externe Expertise konsultieren: Bei hoher Tragweite (medizinisch, rechtlich, finanziell) immer Fachexpertise hinzuziehen.

- Transparenz verlangen: Frag, ob die Antwort auf Daten, Richtlinien oder Annahmen basiert — gute Antworten benennen diese.

9. Fazit

ChatGPT hat keine eigenen Interessen, aber es verhält sich nicht neutral im philosophischen Sinn: Seine Ausgaben sind geprägt von Trainingsdaten, menschlichen Anpassungen, Sicherheitsrichtlinien und dem konkreten Prompt. Es kann kritisch analysieren, doch diese „Kritik“ ist ein Produkt statistischer Mustererkennung – nützlich, aber nicht identisch mit menschlichem Urteilsvermögen oder moralischer Absicht.

Für verantwortungsvolle Nutzung gilt: Nutzer sollten Antworten aktiv hinterfragen, Quellennachweise verlangen und das System als leistungsfähiges, aber fehleranfälliges Werkzeug begreifen.